In un mondo digitale dove la gestione crawler è fondamentale per l’efficienza e lo sviluppo online, il file Robots.txt emerge come uno strumento vitale per la esclusione indicizzazione di pagine non necessarie o private dai motori di ricerca. Questo file di configurazione server, semplice ma potente, è un alleato imprescindibile per la ottimizzazione SEO, permettendo ai webmaster di specificare quali parti del proprio sito web devono essere escluse dal processo di crawling automatico. La conoscenza e l’implementazione corretta di questo file contribuiscono in modo significativo al posizionamento strategico online e all’efficacia generale delle pratiche SEO.

Indice del Contenuto

TogglePunti chiave

- Il Robots.txt è un file utilizzato per prevenire l’indicizzazione di pagine web specifiche da parte dei motori di ricerca.

- Gioca un ruolo cruciale nella gestione crawler e nell’esclusione indicizzazione, influenzando la SEO del sito.

- Questo file di configurazione server consente di escludere sezioni del sito che non si desidera vengano esplorate o indicizzate.

- Una corretta implementazione di Robots.txt è decisiva per migliorare la visibilità e la pertinenza dei contenuti web nelle ricerche online.

- Essenziale nell’ottimizzazione SEO, il file deve essere creato con attenzione per evitare di compromettere la presenza online del sito.

- La manutenzione e la verifica dell’efficacia di Robots.txt sono processi continui nell’evoluzione di una strategia digitale.

Introduzione al file Robots.txt

Nel cuore della gestione di un sito web vi è la continua esigenza di controllare l’interazione con i motori di ricerca, elemento fondamentale per la visibilità e la sicurezza delle piattaforme digitali. In questo contesto, il protocollo di esclusione dei robot gioca un ruolo decisivo, facendo del file Robots.txt uno degli asset più strumentali per la gestione dei bot e l’enforcement delle regole di crawling. Analizziamo quindi la sua definizione e le principali funzioni che lo rendono un pilastro nella costruzione di una presenza online efficace e sicura.

Definizione e Funzione Principale di Robots.txt

Il file Robots.txt si configura come una guida per i bot dei motori di ricerca, indicando loro quali sezioni del sito web indagare e quali escludere. Questo protocollo, interpretato come una sorta di cartello di “ingresso consentito” o “vietato l’accesso”, custodisce la porta d’ingresso alle risorse del server, prevenendo una sovrapproduzione di traffico e la possibile esacerbazione del carico di lavoro su di esso.

L’Importanza di Robots.txt per i Motori di Ricerca

La relevanza del file Robots.txt per i motori di ricerca è inestimabile. Esso non solo protegge contenuti sensibili o ridondanti dallo sguardo pubblico delle SERP, ma contribuisce a delineare la mappatura del sito che influenzerà la pertinenza e la qualità dei risultati di ricerca. La gestione accurata tramite il file Robots.txt si riflette quindi in una presenza online ottimizzata, scevra da contenuti superflui e inlaid nel rispetto delle direttive date, salvaguardando sia l’infrastructure tecnica sia la reputazione digitale del sito web.

La Sintassi del File Robots.txt

Per gestire efficacemente il blocco crawler e indirizzare correttamente i motori di ricerca, è essenziale comprendere la sintassi di base del file Robots.txt. Questa configurazione permette ai webmaster di influenzare l’indicizzazione del proprio sito web definendo regole Robots.txt chiare e precise.

Comprendere le Direttive User-agent e Disallow

Le direttive User-agent sono utilizzate per specificare a quali bot si rivolgono le regole impostate all’interno del file Robots.txt. Ciascun User-agent può avere regole distinte, permettendo un controllo granulare sul comportamento dei diversi crawler dei motori di ricerca. Di seguito, un esempio illustra la loro implementazione:

- User-agent: * – questa direttiva si rivolge a tutti i crawler.

- User-agent: Googlebot – specifica le regole per il bot di Google.

Utilizzando la direttiva Disallow, si indica quali parti del sito non devono essere esplorate o indicizzate dai crawler. L’individuazione accurata delle risorse web tramite questa direttiva è fondamentale per prevenire la visualizzazione di contenuti non desiderati nei risultati di ricerca.

L’Uso di Allow e Sitemap nella Configurazione

Contrariamente a Disallow, la direttiva Allow viene utilizzata per concedere l’accesso a determinate risorse che precedentemente erano state escluse dalle regole di blocco. Questa funzione risulta utile quando si vuole consentire l’indicizzazione di particolari file o cartelle in un percorso altrimenti non accessibile.

Per assistere ulteriormente i crawler nella navigazione del sito e assicurarne una corretta esplorazione delle pagine, viene utilizzata la direttiva Sitemap. Fornire l’URL della mappa del sito è una pratica comune che garantisce ai motori di ricerca una visione completa della struttura del sito.

| Directive | Descrizione | Esempio di Utilizzo |

|---|---|---|

| User-agent | Identifica il tipo di crawler a cui sono dirette le regole | User-agent: * |

| Disallow | Impedisce ai crawler di accedere alle pagine o risorse specificate | Disallow: /private/ |

| Allow | Permette ai crawler di accedere alle risorse alle quali era stato precedentemente negato l’ingresso | Allow: /public/images/ |

| Sitemap | Offre il percorso della mappa del sito ai crawler per una migliore indicizzazione | Sitemap: https://www.example.com/sitemap.xml |

Creare il File Robots.txt: Step by Step

La creazione Robots.txt inizia con la scelta attenta delle risorse da rendere inaccessibili ai bot dei motori di ricerca. Seguendo una guida configurazione dettagliata, è possibile procedere senza intoppi. Ecco i passaggi fondamentali per la redazione del tuo file .txt:

- Identificazione delle Pagine: Determinare quali pagine o sezioni del tuo sito web andranno escluse dalla scansione dei crawler.

- Creazione del File: Redigere un file di testo semplice (.txt) usando un editor come Notepad o TextEdit.

- Indicazioni per i User-agent: Specificare con chiarezza i crawler che devono seguire o meno le direttive contenute nel file.

- Regole di Esclusione: Definire le regole di accesso utilizzando le direttive “Disallow” per bloccare l’accesso o “Allow” per concederlo.

- Sitemap: Inclusione dell’URL completo della sitemap per facilitare i motori di ricerca nell’indicizzazione del sito.

- Controllo Sintassi: Verifica dell’utilizzo corretto della sintassi per evitare errori che potrebbero compromettere l’intera configurazione.

- Posizionamento del File: Caricare il file Robots.txt nella directory radice del sito web, affinché sia facilmente rintracciabile dai motori di ricerca.

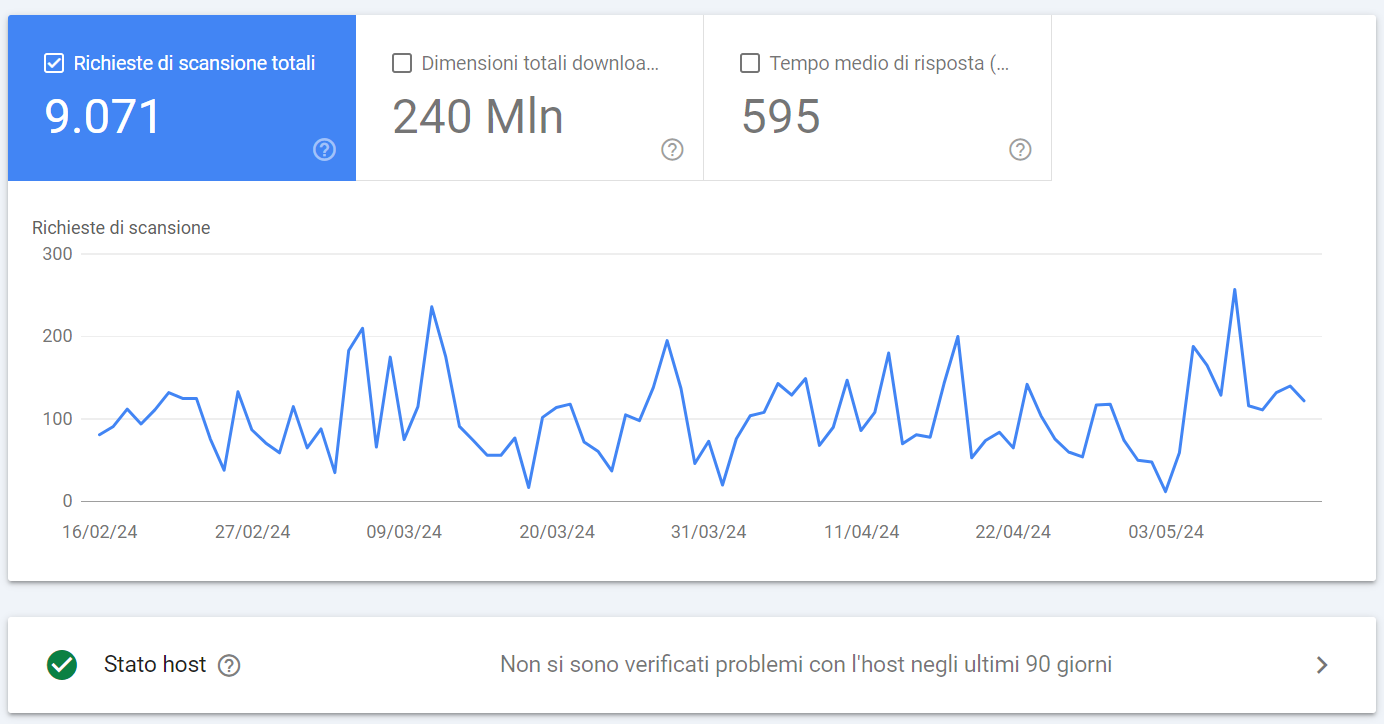

- Test e Verifica: Utilizzare strumenti come Google Search Console per assicurarsi che il file sia letto correttamente e che le direttive siano interpretate come desiderato.

Grazie a questi passaggi, la creazione Robots.txt e la sua corretta implementazione consentiranno di orientare i motori di ricerca verso un’indicizzazione efficace del tuo sito web.

Robots.txt e SEO: Come Ottimizzare per i Motori di Ricerca

Per garantire una solida strategia SEO, l’ottimizzazione indicizzazione sul motore di ricerca parte dal corretto utilizzo del file Robots.txt. Questo strumento è fondamentale per indirizzare i motori di ricerca verso una corretta scansione del sito, assicurando che le pagine critiche siano reperibili e quelle riservate rimangano protette.

Best Practices per Non Ostacolare l’Indicizzazione

Una delle migliori pratiche in una robusta strategia SEO è conducere un’attenta analisi Robots.txt del sito. Implica la revisione delle direttive per essere sicuri che nessuna pagina essenziale sia ostruita dai crawler. Inoltre, è indispensabile verificare che tutte le pagine di valore siano accessibili, contribuendo a una miglior visibilità nei risultati di ricerca.

- Verifica che le pagine di conversione e i contenuti chiave siano indicizzabili.

- Assicurati che i link che puntano alle pagine di importanza strategica siano seguiti.

- Controlla periodicamente le regole di esclusione per evitare di omettere i contenuti nuovi o aggiornati.

Errori Comuni da Evitare nel File Robots.txt

Affinché l’ottimizzazione per i motori di ricerca sia efficace, è necessario evitare errori comuni nel file Robots.txt che potrebbero influenzare negativamente il posizionamento del sito. Di seguito, una tabella illustra gli errori tipici e le soluzioni consigliate per evitarli.

| Errore Comune | Impatto sull’SEO | Soluzione |

|---|---|---|

| Blocco involontario di pagine chiave | Riduce la visibilità di pagine importanti | Utilizza l’analisi Robots.txt per rivedere le regole di Disallow |

| Mancata inserzione della mappa del sito (Sitemap) | Difficoltà per i crawler a scoprire tutte le pagine | Aggiungi la direttiva Sitemap con l’URL corretto nel Robots.txt |

| Utilizzo di sintassi errate | Regole non interpretate correttamente dai motori di ricerca | Consulta le linee guida ufficiali per la corretta formattazione |

Strumenti Utili per l’Analisi e il Testing di Robots.txt

Una verifica efficace del file Robots.txt è fondamentale per qualunque webmaster che desideri ottimizzare la visibilità del proprio sito. Tra i vari strumenti disponibili, la Google Search Console si distingue per la sua capacità di svolgere un test validità del file Robots.txt, identificando potenziali problemi di lettura e interpretazione da parte dei bot di ricerca. Altri strumenti online offrono funzionalità simili, permettendo di analizzare il file per individuare eventuali disallineamenti con le prassi SEO consigliate.

Di seguito, presentiamo una tabella riepilogativa degli strumenti che ogni webmaster può utilizzare per la verifica Robots.txt, insieme alle principali funzionalità che ciascuno offre:

| Strumento | Funzionalità | Punti di Forza |

|---|---|---|

| Google Search Console | Testing e verifica validità Robots.txt | Integrazione con altri servizi Google, report dettagliati |

| Robotstxt.org Analyzer | Analisi della sintassi e delle direttive | Semplicità d’uso, consigli per la correzione |

| Screaming Frog SEO Spider | Scansione e audit del file Robots.txt | Analisi on-site completa, dettagli su blocchi e restrizioni |

Considerando che l’obiettivo è garantire che le politiche di esclusione non compromettano la corretta indicizzazione del sito, uno strumento di test validità è cruciale nell’individuare problemi in fase preventiva. L’utilizzo periodico di questi strumenti è parte integrante di una strategia SEO di successo, per assicurare che i robot dei motori di ricerca possano navigare senza impedimenti e che il contenuto di valore raggiunga i potenziali visitatori.

Consigli per la Gestione Avanzata

Per elevare la qualità del vostro sito nei risultati di ricerca, è essenziale padroneggiare tecniche di personalizzazione crawling e di gestione bots, sfruttando al meglio le funzionalità del file Robots.txt. Scopriamo come implementare filtri avanzati, wildcards e gestire i parametri URL per una gestione avanzata di questo file di configurazione.

Implementazione di Wildcards e Parametri URL

L’utilizzo delle wildcards nel file Robots.txt permette la creazione di pattern dinamici, capaci di adattarsi a diverse URL con un unico comando. Incrementando l’efficacia della personalizzazione crawling, i filtri avanzati consentono di indirizzare i bots in modo preciso e accurato.

- Wildcard

*: usata per rappresentare qualsiasi sequenza di caratteri. - Wildcard

$: segnala la fine di un URL, utilizzata per specificare i tipi di file da escludere.

Conoscere il Limite di Grandezza del File Robots.txt

È importante monitorare la dimensione del file Robots.txt, poiché superare il limite imposto dai motori di ricerca può comportare una lettura parziale del file stesso. Un file troppo ampio potrebbe non essere interamente processato, vanificando gli sforzi di ottimizzazione e gestione bots.

| Motore di Ricerca | Limite Dimensione (approx.) |

|---|---|

| 500 KB | |

| Bing | 10 KB |

| Yahoo! | 10 KB |

Conclusione

L’efficacia nel utilizzo efficace Robots.txt è dimostrata dal suo impatto diretto sulla visibilità di un sito web all’interno delle SERP. L’apprendimento dettagliato delle sue funzionalità, unito alla capacità di crearlo e configurarlo correttamente, rende questo file un elemento imprescindibile per una gestione ottimale SEO. Attraverso i vari passaggi trattati nella guida, ci si addentra in un contesto tecnico fondamentale per tutti coloro che desiderano esercitare un controllo avanzato sulla propria presenza online.

Ricordando di adottare le best practices nei processi di configurazione e aggiornamento del file Robots.txt, ci si può assicurare che tutte le pagine rilevanti del sito siano correttamente accessibili ai bot dei motori di ricerca. Simultaneamente, è fondamentale evitare gli errori comuni che potrebbero compromettere la visibilità delle risorse online, e di conseguenza, il raggiungimento di obiettivi SEO strategici. L’attenzione a dettagli come questi può fare la differenza tra un sito che eccelle e uno che rimane in ombra.

In conclusione, il Robots.txt si conferma uno strumento vitale, che ben maneggiato, contribuisce alla crescita del valore e dell’autorità di un sito nel contesto digitale. L’implementazione di queste pratiche è un investimento nel futuro digitale di un’entità online, rinforzando la struttura per una scalata efficace nei confronti dei motori di ricerca più utilizzati. Con una utilizzo efficace Robots.txt e un’oculata gestione ottimale SEO, il successo in questo ambiente così competitivo è maggiormente assicurato.